深度解析:构建专业的搜索引擎

- 游戏资讯

- 2024-12-31

- 44

在数字信息爆炸的时代,专业的搜索引擎不仅是互联网信息检索的核心工具,也是技术进步与用户需求交汇的产物。构建一个专业的搜索引擎是一项复杂而精细的工作,它要求技术者不仅需要具备深厚的算法知识,还要对用户体验有深刻的理解。本文将向您展示构建一个专业搜索引擎所需的核心要素、步骤以及潜在的挑战,帮助您深入理解搜索引擎的构建过程。

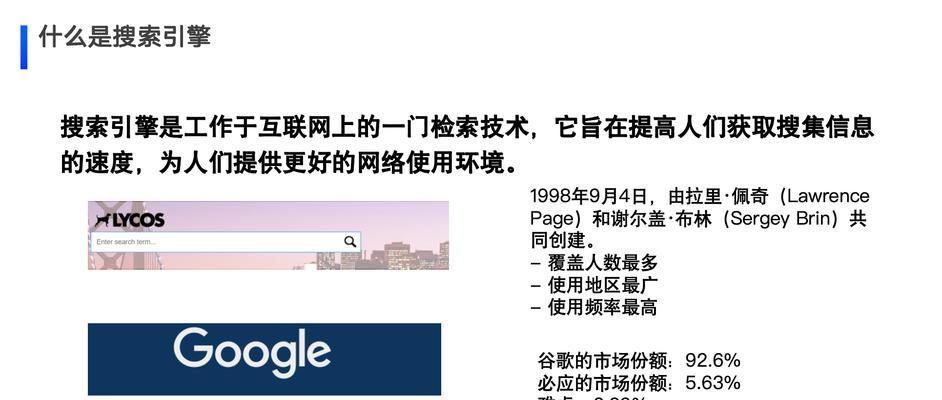

核心要素:理解搜索引擎的基础架构

构建专业搜索引擎的第一步是理解其基础架构。一个基本的搜索引擎通常包括以下几个核心组件:

1.爬虫(Crawler):爬虫,也称蜘蛛或机器人,是搜索引擎的重要组成部分,它负责遍历互联网并收集网页数据。其设计需要考虑如何高效抓取网页、存储数据以及处理反爬虫机制。

2.索引(Indexer):索引是存储和组织所收集数据的过程,它能够帮助搜索引擎快速找到相关信息。一个高效的索引系统能够极大提升搜索引擎的响应速度。

3.搜索算法(SearchAlgorithm):这是搜索引擎的心脏,负责处理用户的查询请求,匹配索引数据库,并按照相关性排序返回结果。算法的优化对提升搜索质量和用户体验至关重要。

操作步骤:构建专业搜索引擎的步骤

1.设计爬虫策略

您需要设计一个爬虫策略,以确定哪些网页值得抓取,这通常涉及对网站结构、链接关系和内容质量的分析。应对法律法规和网站的Robots协议保持尊重,避免侵犯版权或隐私。

2.建立索引

3.构建搜索算法

搜索算法的构建是核心技术之一,它涉及自然语言处理、机器学习等多个领域。该算法不仅要能够理解用户的查询意图,还应能从大量信息中快速筛选出最相关的内容。

4.用户界面设计

用户界面是用户与搜索引擎交互的界面。界面设计需要简洁明了,确保用户能够轻松输入查询,清晰阅读搜索结果,并能快速找到所需信息。

5.测试与优化

构建完成后,需要对搜索引擎进行测试,包括系统稳定性测试、性能测试和用户体验测试等。根据测试结果不断优化搜索引擎,以达到最佳的搜索效果。

问题与挑战:构建专业搜索引擎的常见问题

在构建搜索引擎的道路上,您可能会遇到多种挑战:

技术挑战:如何提高爬虫的抓取效率,如何创建高准确率的索引系统,以及如何优化搜索算法,都是技术上的难点。

数据处理:海量数据的存储和处理是大数据时代搜索引擎面临的一大挑战。如何保证数据的实时性和准确性,是搜索引擎必须解决的问题。

用户体验:提供相关性强、准确度高的搜索结果是吸引用户的关键。如何根据用户的行为和偏好个性化搜索结果,提升用户满意度,是持续研究的方向。

法律与伦理:如何在满足用户信息需求的同时,保护版权、隐私及遵守相关法律法规,是每个搜索引擎经营者都必须面对的问题。

结语

构建专业的搜索引擎是一个需要跨学科知识、多技术融合以及对用户体验深度理解的复杂过程。通过本文的介绍,您应该对搜索引擎的基础架构、构建步骤以及面临的挑战有了全面的认识。随着技术的不断进步,我们可以预见搜索引擎将在未来扮演更加重要的角色,为人们的信息检索和知识获取提供更加精准高效的服务。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-9246-1.html