搜索引擎的定义及其运作机制深度解析

- 游戏资讯

- 2024-12-27

- 28

在浩瀚的互联网信息海洋中,搜索引擎是帮助我们快速找到所需信息的指南针。无论是学术研究、工作查询还是日常娱乐,搜索引擎为我们的信息搜集提供了极大的便利。搜索引擎究竟是什么?它是如何运作的?本文将为您提供一份全面的搜索引擎定义及其运作机制的解析,帮助您更好地了解这一互联网关键技术。

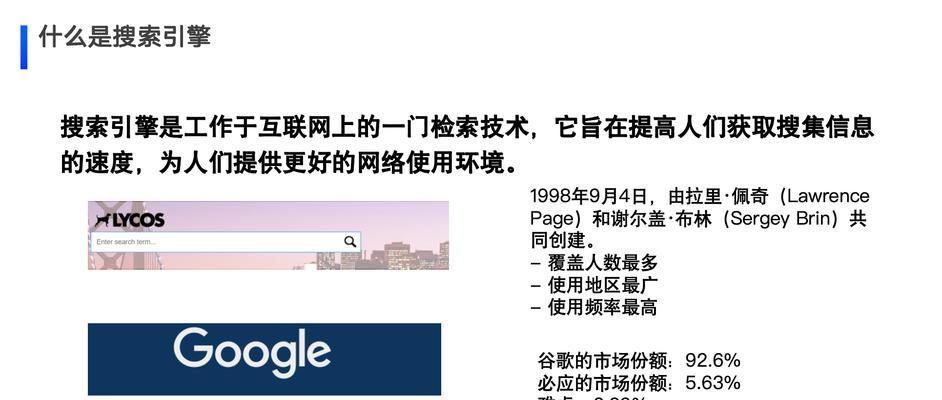

搜索引擎的定义

在搜索引擎的定义中,我们可以将其看作一个用来查找互联网上信息的系统。它能够根据用户输入的查询词,自动在互联网上搜集、索引相关信息,并对结果进行排序,最终将最相关和权威的网页呈现给用户。这一过程主要由三个主要组件构成:爬虫(Crawler)、索引器(Indexer)和搜索接口(SearchInterface)。

爬虫(Crawler)

爬虫,又称网络蜘蛛(WebSpider)、网络机器人(WebRobot)或搜索引擎机器人(SearchEngineBot),它的作用在于遍历互联网,访问各种网站,读取网页内容,并将其存储下来。其工作原理类似于人类在图书馆中通过书目索引找到书籍。爬虫会通过链接来“跳跃”访问网页,同时遵循网站的robots.txt规则,以决定哪些页面可以爬取。

索引器(Indexer)

索引器则是将爬虫采集来的信息进行处理,它负责分析网页内容,提取关键词并进行分类,存储在索引数据库中。索引数据库的构建类似于图书馆的图书索引系统,索引器将能够快速定位到关键字所在的网页,为搜索查询提供基础。

搜索接口(SearchInterface)

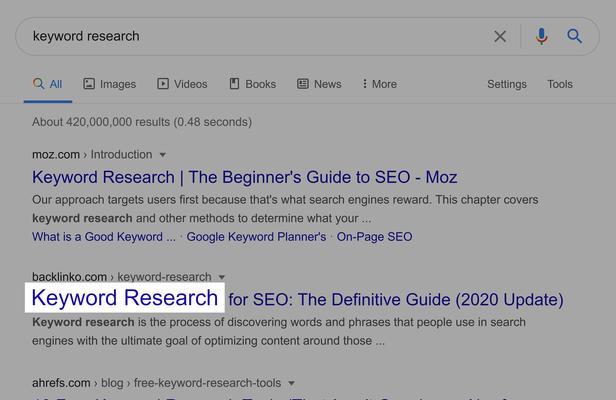

搜索接口提供了一个用户与搜索引擎交互的界面。用户输入查询词后,搜索引擎通过算法对索引数据库中的数据进行快速检索,并将搜索结果以排名的形式展现给用户。这些结果通常是基于相关性、权威性、新鲜度等多维度指标进行排序。

搜索引擎的运作机制

了解了搜索引擎的定义之后,我们来深入探讨一下其运作机制。这一机制大致可以分为以下几个步骤:

1.网络爬取(WebCrawling)

搜索引擎首先启动爬虫对互联网进行爬取。爬虫访问网页,并遵循网页上的链接,进而访问更多页面。在爬取过程中,它会读取网页内容,并将其复制一份存入搜索引擎的数据库中。这一步骤是搜索引擎获取数据的基础。

2.页面索引(PageIndexing)

在页面被爬取之后,搜索引擎会利用索引器对这些页面进行处理。索引器会分析页面的内容,提取关键词,并建立索引。索引可以简单理解为数据库中的一个条目记录,它包含了关键词和存储这些关键词的网页之间的映射关系。

3.查询处理(QueryProcessing)

用户在搜索框中输入查询词后,搜索引擎会进行查询处理。这一过程包括了解用户的查询意图、分析查询词的语法结构,以及考虑用户的个性化需求等。

4.搜索结果排名(SearchResultsRanking)

对用户查询做出响应后,搜索引擎会根据自己的算法对数据库中与查询词相关的页面进行排名。这一过程是搜索引擎技术的核心,涉及数百个因素,包括页面内容的相关性、网站的权威性、用户的地理位置、点击率等。

5.结果呈现(ResultsPresentation)

搜索引擎会将排名后的搜索结果呈现给用户。在结果列表中,通常会显示网页标题、URL、简短描述(MetaDescription)等信息。用户点击结果链接后,即跳转到相应的网页上。

搜索引擎的重要性

搜索引擎不仅仅是一个技术产品,它在我们的日常生活和工作中扮演了极为重要的角色。一方面,它帮助用户快速准确地找到所需信息,提高了信息检索的效率;另一方面,它也为互联网内容的展示和推广提供了平台,对广告商、网站所有者以及内容创作者都有着深远的影响。

综上所述,搜索引擎是互联网中不可或缺的工具,它以一种自动化的方式极大提高了信息检索的效率。理解搜索引擎的定义和运作机制,不仅有助于我们更好地使用这项服务,也对我们从事网络营销、电子商务等工作有深远的影响。未来,随着人工智能和机器学习技术的进步,搜索引擎将会更加精准和智能化,为人们提供更加个性化的搜索体验。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-8647-1.html

上一篇

抖音seo