爬虫实战:爬取bilibiliTop100热门视频信息

- 游戏资讯

- 2024-12-20

- 4

在互联网信息泛滥的时代,如何准确获取和分析特定网站的数据成为了一个值得探讨的课题。本篇文章将带您一起实战演练,重点介绍如何使用Python编写爬虫程序,爬取bilibili上排名前100的热门视频信息。这项技能不仅适用于数据分析爱好者,同样适合需要进行市场调研的营销人员,甚至对普通用户了解流行趋势也非常有帮助。

爬虫概述与必要性

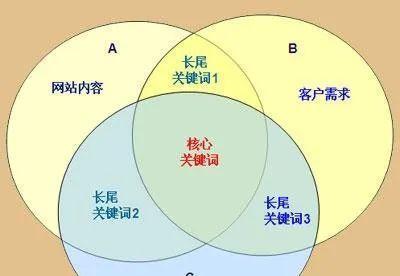

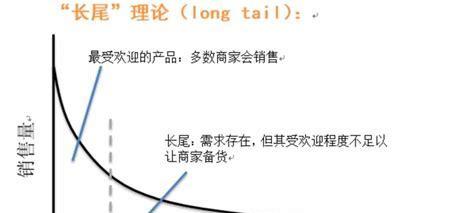

网络爬虫是自动获取网页内容的机器人程序,它按照既定的规则,在互联网上自动搜索、抓取所需信息。在SEO优化中,理解目标网站的热门内容有助于提升网站的营销效果。我们需要了解爬虫的基本操作原理及为何要学习爬虫技术。

为什么需要爬取bilibili热门视频信息?

市场分析:通过分析bilibili上的热门视频,可以了解当前流行的视频内容,为市场营销定位提供参考。

内容策划:作为内容创作者,爬取热门视频数据可以帮助策划符合用户兴趣的视频,提高作品的热度。

SEO研究:了解bilibili上的热门内容,可以帮助更好地优化自己的视频内容,提升在平台上的搜索排名。

准备工作:Python环境与库安装

为了实现上述目标,第一步是设置好Python环境并安装所需的第三方库。推荐使用Anaconda进行环境管理,因为它的包管理功能强大,安装简化,非常适合数据分析。

安装第三方库

以下为我们将要使用的第三方库,以及它们的主要作用:

`requests`:用于发起网络请求。

`beautifulsoup4`:用于解析HTML文档。

`pandas`:用于数据处理和分析。

具体安装命令如下:

```bash

pipinstallrequestsbeautifulsoup4pandas

```

编写爬虫程序:关键步骤

第一步:了解bilibili的API

在正式编写爬虫前,我们需要了解bilibili是否有公开的API接口可以调用。公开API可以合法、方便地获取数据,但如果没有公开API或功能有限,我们可能需要通过解析网页的方法来获取数据。

第二步:请求网页数据

通过Python的`requests`库,我们可以发送HTTP请求并获取网页内容。重要的是模拟浏览器的行为,从而获取响应数据。

示例代码如下:

```python

importrequests

url="目标网页的URL"替换为实际的URL地址

headers={

'User-Agent':'你的User-Agent',替换为实际的User-Agent

其他可能需要的HTTP头部信息

response=requests.get(url,headers=headers)

检查请求是否成功

ifresponse.status_code==200:

print(response.text)

else:

print("请求失败,状态码:",response.status_code)

```

第三步:解析网页内容

获取到网页的内容后,我们使用`beautifulsoup4`库来解析HTML文档,提取我们需要的视频信息,如标题、播放量、弹幕数等。

示例代码如下:

```python

frombs4importBeautifulSoup

soup=BeautifulSoup(response.text,'html.parser')

假设我们要提取视频标题

video_titles=soup.find_all('a',class_='视频标题的CSS类')

titles=[item.textforiteminvideo_titles]

print(titles)

```

第四步:存储爬取的数据

将爬取的数据保存到文件中,可以使用`pandas`库创建DataFrame,进一步保存为Excel或CSV格式,方便后续的数据分析。

示例代码如下:

```python

importpandasaspd

创建DataFrame并填充数据

df=pd.DataFrame({

'标题':titles,

'其他信息':其他信息列表

保存数据

df.to_csv('bilibili_hot_videos.csv',index=False)

```

遇到的问题与解决方案

在爬虫的实战过程中,我们可能会遇到各种问题,例如:

反爬虫机制:许多网站都有防止爬虫的机制。解决这一问题的办法有:设置合理的请求间隔、模拟正常的用户行为、使用代理IP等。

数据解析困难:有时候网页结构复杂,传统的解析方法无法准确提取数据。这时可以考虑使用Selenium等浏览器自动化工具。

以上步骤展现了从请求网页、解析内容到数据存储的爬虫基本流程。初学者应注重实践,逐步积累经验,从而熟练掌握爬虫技术。

注意事项

在尝试爬取数据时,必须遵守法律法规以及目标网站的使用条款。不要过度请求以免对网站服务造成影响,同时尊重数据的版权和隐私。

通过本文的介绍,您已经了解了爬取bilibiliTop100热门视频信息的基本流程。实际上,爬虫技术是一门深奥且实用的技能,它可以帮助我们从海量的网络数据中获取有价值的信息。希望本文能够帮助您在爬虫学习的道路上迈出坚实的一步,并在未来能够根据自己的需求开发出更多实用的数据爬取工具。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-6282-1.html