谷歌tpu是什么?谷歌tpu如何提高计算效率?

- 游戏资讯

- 2025-01-31

- 23

导言

随着人工智能技术的跨越式发展,机器学习模型变得越来越复杂,对计算资源的要求亦水涨船高。谷歌推出的TensorProcessingUnit(TPU),作为专为机器学习和深度学习计算而设计的芯片,正逐渐成为工业级应用的颠覆者。本文将详细介绍TPU的发展背景、技术优势、应用场景以及未来趋势。

TPU的诞生背景与核心功能

机器学习与硬件需求的进化

在传统的CPU和GPU难以满足日益增长的AI计算需求的背景下,谷歌的工程师们意识到需要一种全新的硬件架构来推动人工智能技术的发展。2016年,谷歌公开了TPU的首个版本,标志着专门为机器学习任务量身定制的硬件时代的到来。

强大的机器学习加速能力

TPU针对机器学习特别是深度学习的常见计算模式,如矩阵乘法、卷积等,进行了优化。它能够大幅提升运算效率,显著减少所需时间,为谷歌云平台的用户提供了前所未有的计算加速体验。

TPU的核心优势与关键技术突破

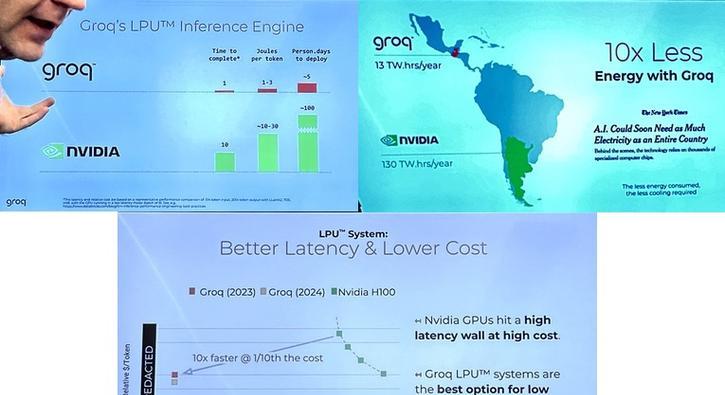

高效能与低延迟

与传统处理器相比,TPU的设计集中于减少模型推理过程中的延迟时间,提高执行效率。TPU能够在保持高吞吐量的同时实现低延迟,这对于实时或者近实时的AI应用至关重要。

谷歌的专用集成电路(ASIC)设计

TPU使用了专用集成电路(ASIC)技术,这是一种可以根据特定应用需求设计的芯片。ASIC相比于通用处理器更能够有效地执行特定算法和操作,这使得TPU在机器学习任务上可以达到性能的极致优化。

TPU的应用场景与市场反响

广泛的运用领域

TPU已经被应用于包括自然语言处理、图像识别、语音识别和推荐系统在内的多个领域。这些应用往往要求高速度、高准确性和低延迟,TPU正契合了这些需求。

市场认可度的提高

随着AI技术的普及,越来越多的企业和创业者开始寻求性能强大且成本效益高的计算解决方案。TPU的推出满足了这一市场缺口,赢得了高度的市场认可。

TPU的未来发展方向与挑战

硬件技术的持续迭代

技术的演进推动着TPU不断地进行迭代升级。从TPU1到TPU3,每一代产品都在性能、能效、规模等方面取得显著进步。

面临的新挑战

尽管TPU取得了巨大的成功,但它也面临着新的挑战,例如随着AI模型的进一步增大,TPU在处理大规模并行计算任务时可能会遇到新的优化难题。同时,随着量子计算等新一代计算技术的崛起,TPU需要不断适应新的技术环境。

结语

在人工智能技术飞速发展的今天,TPU以其卓越的性能和效率正成为推动行业前进的关键力量。作为谷歌AI战略的重要组成部分,TPU将继续引领机器学习硬件的发展潮流,为未来更智能的世界贡献力量。

通过以上内容,我们对谷歌TPU有了全面而深入的了解。从技术原理到实际应用,TPU无愧于机器学习加速的利器之美誉。面对未来挑战,人们期待TPU以及类似技术能够解锁人工智能更多的潜能,共同迎接智能时代的新篇章。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-18948-1.html