知乎关键词搜索爬虫怎么做?如何制作知乎关键词搜索爬虫?

- 游戏资讯

- 2025-01-24

- 28

在互联网信息不断膨胀的今天,如何快速有效地获取所需信息已经成为了一项重要技能。对于个人或企业来说,拥有一个能够高效搜索并分析知乎平台上关键词的爬虫工具,无疑是获取行业动态、市场信息以及用户反馈的有力武器。本文将深入探讨如何制作知乎关键词搜索爬虫,并确保内容既专业又易于理解,旨在为初学者提供清晰的指导。

一、了解爬虫及其在知乎的应用

1.1什么是爬虫?

爬虫,也称为网络蜘蛛或网络机器人,在SEO(搜索引擎优化)领域,它是一种自动化抓取互联网信息的程序。它可以按照一定的规则,自动访问互联网上的网页,抓取特定的数据。

1.2知乎对爬虫的态度

知乎作为一个知识问答社区,为了避免滥用爬虫对用户体验和数据安全造成不利影响,对爬虫有严格的规定。在制作和使用知乎关键词搜索爬虫前,必须遵守知乎的爬虫政策,并合理控制访问频率和数据抓取的范围。

二、制作知乎关键词搜索爬虫的步骤

2.1选择合适的编程语言与工具库

在编写爬虫之前,你需要选择一种编程语言。Python是制作爬虫的热门选择,它拥有丰富的库,如`requests`用于发起网络请求,`BeautifulSoup`或`lxml`用于解析HTML页面,以及`Selenium`用于模拟浏览器操作。

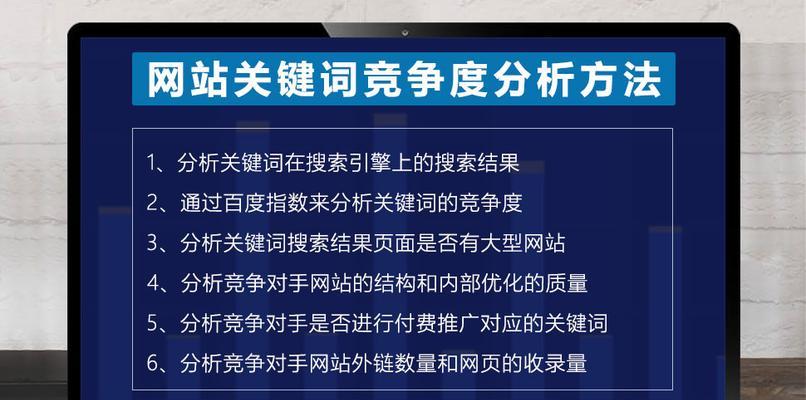

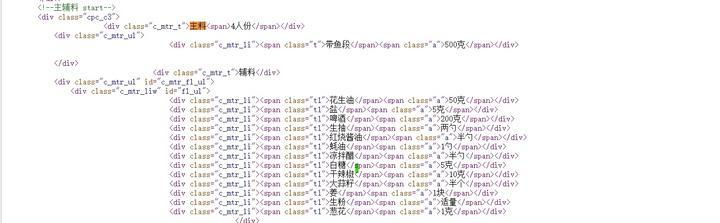

2.2分析知乎的搜索结果页面

在编写爬虫代码之前,先要对知乎的搜索结果页面进行分析,理解其URL结构、搜索参数和结果的HTML结构。

2.3编写爬虫代码

具体编写过程中,你需要依次完成以下任务:

使用合适的库发送HTTP请求获取搜索页面的HTML源码。

解析HTML,提取出包含关键词的帖子信息。

处理分页,遍历所有相关搜索结果。

遵守知乎的robots.txt规则,合理设置请求间隔。

2.4数据存储

采集到的数据需要存储在本地或云端数据库中,便于后续分析。可以使用如`pandas`、`SQLite`等工具进行数据存储。

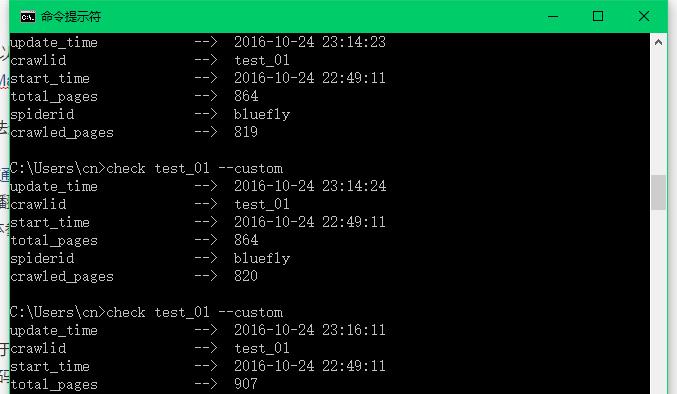

2.5异常处理和日志记录

确保爬虫程序具备良好的异常处理机制和日志记录功能,以便于问题追踪和程序维护。

三、遵守法律法规和知乎的政策

3.1遵守法律法规

要确保爬虫的使用不违反相关法律法规,比如计算机信息网络国际联网安全保护管理办法等。

3.2尊重知乎的用户协议

在制作和使用爬虫时,务必遵循知乎平台的用户协议,避免对知乎服务器造成过大压力。

四、实用技巧和注意事项

4.1使用代理IP

为了避免被知乎封禁,可以使用代理IP进行爬虫操作。

4.2研究知乎反爬虫机制

了解和研究知乎网站的反爬虫机制,采取相应措施应对,比如设置合理的请求头信息、使用JavaScript渲染的数据抓取策略等。

4.3严格控制爬虫行为

严格控制爬虫的行为,避免对知乎的正常运营造成影响。

五、常见问题解答

5.1知乎关键词搜索爬虫可能会遇到哪些问题?

频繁的访问请求可能会被知乎平台识别为异常行为并加以限制。

知乎可能更改页面结构或反爬虫策略,导致爬虫失效。

5.2如何解决这些问题?

设计合理的爬虫抓取策略,避免过于频繁的访问。

定期检查和更新爬虫代码,以应对知乎的变化。

六、结语

通过以上步骤,你可以制作出一个基本的知乎关键词搜索爬虫。记住,在享受爬虫带来的便利的同时,一定要遵守法律法规和平台规则,尊重用户隐私,维护一个良好的网络生态环境。制作爬虫是一个细致且需要不断学习的过程,希望本文的内容能够成为你在这个领域探索旅程的第一个起点。

接下来,你可以尝试结合所学知识实际编写代码,逐步完善和优化你的知乎关键词搜索爬虫。祝你在数据挖掘的道路上越走越远!

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-16058-1.html