知乎关键词搜索爬虫:打造高效信息获取工具

- 游戏资讯

- 2025-01-06

- 29

在信息爆炸的时代,数据的收集和分析变得尤为重要。无论是专业人士还是普通用户,获取精准信息的需求日益迫切。知乎作为中国最大的问答社区,在这里你可以找到无数专业人士与热心网友的见解与经验分享。本文将带你了解如何打造一个知乎关键词搜索爬虫,以便高效地从知乎上提取所需信息。

什么是知乎关键词搜索爬虫?

知乎关键词搜索爬虫是一种自动化的网络数据抓取工具。它能够根据用户指定的关键词,自动在知乎平台上搜索相关信息,帮用户节省大量筛选信息的时间。这种工具通常集成了搜索引擎优化(SEO)的技术,更好地帮助用户定向搜集数据。

制作知乎关键词搜索爬虫的必要条件

在开始编写爬虫之前,需要了解一些基本的条件和准备工作:

了解法律边界:确保你的爬虫活动遵守相关法律法规以及知乎网站的爬虫政策。

编程能力:掌握至少一种编程语言,如Python,对网络爬虫有一定的了解。

熟悉爬虫框架:例如Scrapy或BeautifulSoup,这些框架能够帮助你更高效地编写爬虫代码。

了解API使用:很多平台都提供了API接口,合理使用API可以减少对服务器的负担,也更加稳定。

步骤一:环境准备

在正式编写爬虫之前,需要准备好开发环境:

1.安装Python环境,确保版本稳定且兼容。

2.安装必要的库,如requests库用于发送网络请求,lxml或BeautifulSoup用于解析网页内容。

3.创建项目文件夹,用于存放项目代码和数据。

步骤二:编写爬虫脚本

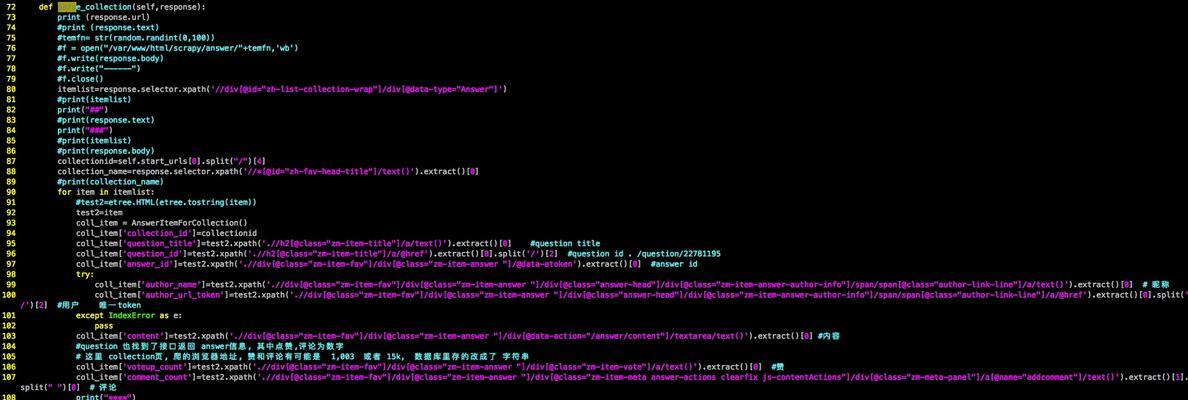

接下来,我们要编写爬虫脚本。这里以Python语言为例:

1.分析目标网页:使用浏览器的开发者工具查看知乎的搜索结果页面结构。

2.编码爬虫逻辑:编写代码以模拟用户在知乎的搜索行为。

3.解析结果数据:使用lxml或BeautifulSoup解析返回的HTML文档。

4.存储数据:将解析后的数据存入本地文件或数据库。

步骤三:测试和优化

编写完成爬虫脚本后,需要进行测试并根据需要进行优化:

1.测试爬虫的抓取效果,确保数据的准确性和完整性。

2.调整抓取频率,避免对目标网站造成过大压力。

3.使用代理IP和User-Agent轮换等技术,防止被封禁。

4.定期更新代码,应对知乎网页结构的变动。

步骤四:维护与升级

爬虫上线后,还需要做好维护和升级工作:

1.定期检查爬虫运行状态,确保数据更新流畅。

2.对比分析数据变化,及时更新关键词和数据抓取策略。

3.根据技术发展和业务需求,对爬虫进行功能拓展和性能优化。

常见问题解答

爬虫会违反知乎的服务条款吗?

遵从知乎的用户协议和服务条款是使用爬虫的先决条件。应当尊重网站的robots.txt文件规定,合理设置爬虫抓取频率和范围。

如何确保爬虫的稳定运行?

增加错误处理机制,对可能出现的网络问题、页面结构变动等问题进行处理。同时做好数据备份,确保数据不会丢失。

如何处理重复数据?

在数据存储之前,通过算法判断是否为重复内容,并设计合理的数据结构以去除冗余。

综上所述

掌握知乎关键词搜索爬虫的制作和使用,能显著提高信息检索的效率和准确性。然而,用户的隐私和网站的正常运行需要我们共同尊重和维护。在使用爬虫的过程中,一定要遵守相关法律法规和网站政策,合理开发和应用这项技术。希望本文的内容能够帮助你顺利制作出符合需求的知乎关键词搜索爬虫。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.jumeiyy.com/article-10779-1.html